El gran sueño digital: Una historia de ambición humana

Indice:

- Presentación

- Introducción

- El legado de la computación

- El sueño inicial: automatizar el pensamiento lógico

- Pensamiento profundo: una extensión de la mente humana

- De cálculo a creatividad: nace la computadora personal

- Conectar al planeta

- Nunca inventamos tan rápido, pero…

- El presente y futuro

- ¿Y ahora qué soñamos?

- ¿Y si el próximo gran invento fuera ético?

Presentación

Todo comenzó con una pregunta sencilla:

¿Y si pudiéramos construir una máquina que pensara por nosotros?

Hoy, esas máquinas existen. Algunas escriben poemas. Otras conducen autos. Algunas nos cuidan. Otras nos desafían.

Pero quizás el verdadero sueño y el más humano de todos no era construir máquinas inteligentes…

Sino construir una sociedad más sabia.

Y ese capítulo…

aún lo estamos escribiendo.

Las máquinas están evolucionando más rápido que los humanos.

Samuel Butler, 1863

Introducción

Para entender el sueño de la humanidad al crear las primeras computadoras, debemos mirar más allá de los circuitos y las pantallas. Tenemos que regresar al contexto histórico en el que nacieron estas máquinas: un mundo marcado por guerras, avances científicos vertiginosos y la necesidad de resolver problemas que desbordaban la capacidad humana.

Las primeras computadoras no surgieron por casualidad, ni fueron simples herramientas de cálculo. Fueron hijas de una época de urgencia y visión. Nacieron del deseo de liberar al ser humano del peso del trabajo repetitivo, de ampliar los límites del pensamiento, y de acelerar el acceso al conocimiento. Eran, en esencia, el intento humano de construir una extensión de su propia mente.

Lo que comenzó como una ambición técnica “hacer cálculos más rápido o procesar datos con eficiencia” pronto se transformó en un sueño más profundo: crear máquinas que pensaran, que ayudaran, que colaboraran, que comprendieran. Un sueño que ha evolucionado con cada generación de tecnología, y que aún hoy sigue tomando nuevas formas, desde asistentes inteligentes hasta inteligencia artificial avanzada.

En esta historia, exploraremos cuál fue ese sueño original, qué metas inspiraron la creación de las primeras computadoras, y cómo ha cambiado esa visión a lo largo del tiempo.

El legado de la computación

Antes de que existieran las computadoras digitales, la humanidad ya había creado máquinas para calcular, automatizar tareas y transmitir información. Algunas eran totalmente mecánicas, otras combinaban mecanismos con electricidad.

- Máquinas de cálculo: Como el ábaco, la Pascalina o la máquina de Babbage, ayudaban a realizar operaciones matemáticas de forma más rápida y precisa.

- Autómatas: Eran dispositivos mecánicos que imitaban acciones humanas o animales, como escribir, tocar música o moverse, programados con engranajes y resortes.

- Máquinas de oficina y comunicación: Telégrafos, teléfonos, máquinas de escribir y tabuladoras procesaban o transmitían datos en empresas, gobiernos y servicios públicos.

- Máquinas electromecánicas: A mediados del siglo XX, aparatos como el Z3, el Harvard Mark I o la Bombe de Turing mezclaban electricidad y mecanismos para resolver cálculos complejos y problemas militares.

Estas máquinas sentaron las bases de la computación moderna, y fueron los primeros pasos concretos del sueño humano de crear inteligencia en forma de máquina.

El sueño inicial: automatizar el pensamiento lógico

Décadas de 1930–1940

Imagina un mundo al borde del colapso. Europa está en guerra, los gobiernos libran batallas no solo en los campos sino también en los laboratorios, y los científicos se convierten en soldados del pensamiento. En ese escenario de caos y descubrimiento, nace una idea tan simple como poderosa:

¿Y si pudiéramos construir una máquina que pensara por nosotros?

Pero no se trataba aún de pensar como nosotros, sino de pensar mejor que nosotros en ciertas cosas: resolver ecuaciones más rápido, calcular trayectorias con precisión milimétrica, desencriptar mensajes antes de que fuera demasiado tarde. Era el tiempo de los cerebros electrónicos, aunque todavía no se llamaban así.

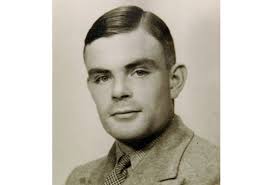

En los sótanos del gobierno británico, un joven matemático llamado Alan Turing imaginaba una máquina que pudiera descifrar los secretos del enemigo. No una máquina de guerra, sino una máquina de lógica. La Bombe, su creación, ayudó a descifrar los mensajes de Enigma y cambió el curso de la historia.

Mientras tanto, al otro lado del Atlántico, gigantes de cables y válvulas como el ENIAC comenzaban a rugir en universidades y laboratorios militares. Eran enormes, ruidosas, casi vivas. No cabían en una habitación. Tenían una sola misión: pensar más rápido de lo que un ejército de matemáticos podría hacerlo jamás.

En Alemania, Konrad Zuse soñaba en silencio con una máquina que pudiera programarse como un lenguaje. En lugar de números, pensaba en instrucciones, en lógica. Sin saberlo, abría la puerta a algo mucho más grande.

En esta época no se hablaba todavía de inteligencia artificial, ni de conciencia digital. El sueño era más pragmático, casi desesperado:

- Resolver cálculos imposibles con lápiz y papel.

- Predecir el futuro del proyectil antes de que se disparara.

- Entender el mundo físico sin tener que destruirlo para comprobar teorías.

Las máquinas eran aliadas silenciosas. No opinaban. No dudaban. Solo obedecían órdenes lógicas y ejecutaban tareas que quemaban neuronas humanas.

Pero en el fondo, había algo más. Aunque dominado por la urgencia de la guerra, este primer sueño tecnológico escondía una intuición poderosa:

Si una máquina puede pensar un poco, tal vez un día pueda pensar mucho.

Y si piensa mucho, tal vez pueda ayudarnos a pensar mejor que nosotros mismos.

La semilla estaba plantada. Lo que entonces parecía solo un cálculo acelerado, era en realidad el inicio de una revolución mental.

La humanidad había creado por primera vez un espejo lógico.

Y en ese reflejo, empezaríamos a preguntarnos:

¿Qué más podría pensar una máquina, si se lo enseñamos?

Tres máquinas, tres caminos: los primeros cerebros artificiales

En medio del caos de la guerra y el asombro científico, tres máquinas marcaron hitos silenciosos que hoy reconocemos como los pilares de la computación. Cada una con una historia distinta, un propósito concreto, y un destino muy diferente.

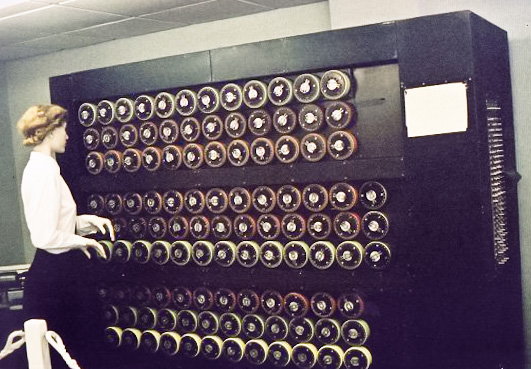

La Bombe de Turing: el ingenio contra el silencio enemigo

La historia de esta máquina no se mide en bits ni en ciclos por segundo, sino en vidas salvadas.

En 1940, mientras los submarinos alemanes hundían barcos en el Atlántico, un joven matemático británico llamado Alan Turing lideraba un equipo secreto en Bletchley Park. Su misión: descifrar los mensajes cifrados por la máquina Enigma, el sistema de comunicación más seguro del Tercer Reich.

Turing no construyó una computadora general, sino una máquina específica: la Bombe. Esta ingeniosa estructura electromecánica probaba miles de combinaciones de claves en paralelo para descubrir cómo se habían cifrado los mensajes.

Aunque la Bombe no era programable ni consciente, su propósito era profundamente humano: proteger vidas con lógica pura. Su éxito fue silencioso, mantenido en secreto por décadas. Al terminar la guerra, todas las Bombes fueron desmanteladas.

Pero su legado sobrevivió: el pensamiento de Turing dio forma a la idea moderna de lo que significa “computar”.

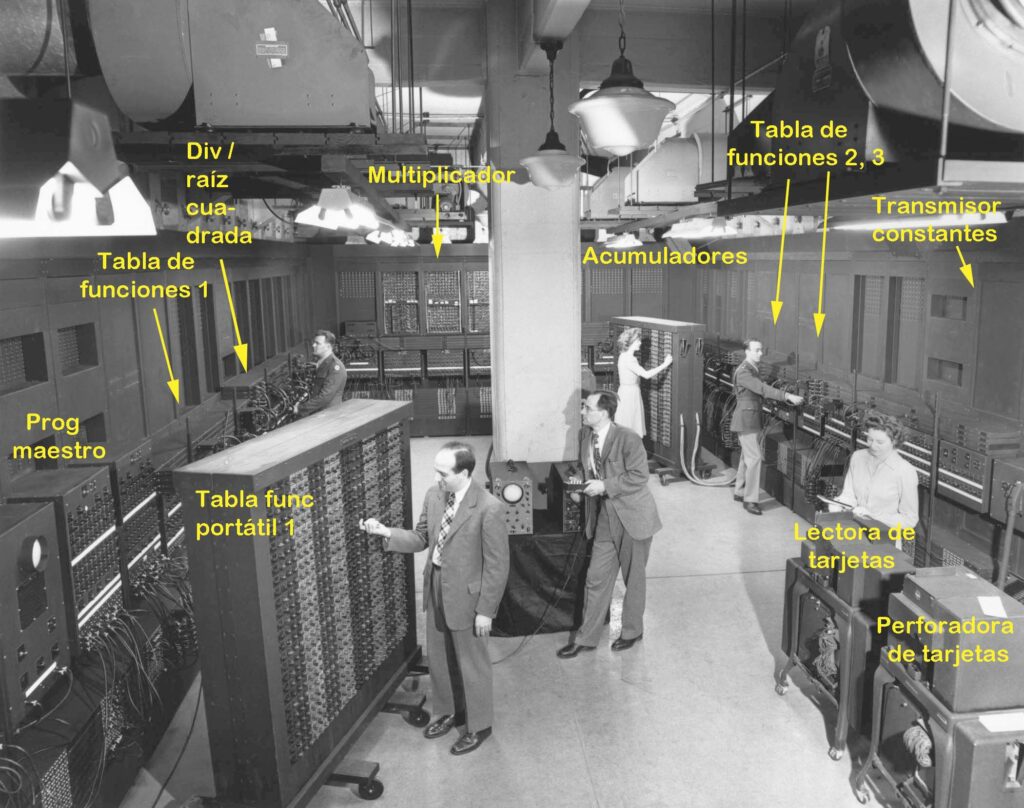

ENIAC: el gigante que aprendió a contar con electricidad

Mientras Europa ardía, en Estados Unidos otro tipo de guerra se libraba: la del cálculo. El ejército necesitaba resolver ecuaciones balísticas complejas para saber dónde caerían los proyectiles disparados desde cañones, aviones o barcos.

En 1945, nacía ENIAC (Electronic Numerical Integrator and Computer), una mole de 27 toneladas, con más de 17,000 válvulas electrónicas. No tenía pantalla, ni teclado, ni ratón. Pero podía realizar en segundos cálculos que antes llevaban días.

Diseñada por Eckert y Mauchly, la ENIAC fue la primera computadora electrónica de propósito general. Aunque programarla requería mover cables y girar interruptores, representaba un antes y un después: la velocidad del pensamiento humano empezaba a tener un aliado eléctrico.

ENIAC fue el puente entre las calculadoras mecánicas del pasado y las computadoras programables del futuro. Sobre sus cimientos nacerían el EDVAC, la arquitectura de von Neumann, y todo lo que vendría después.

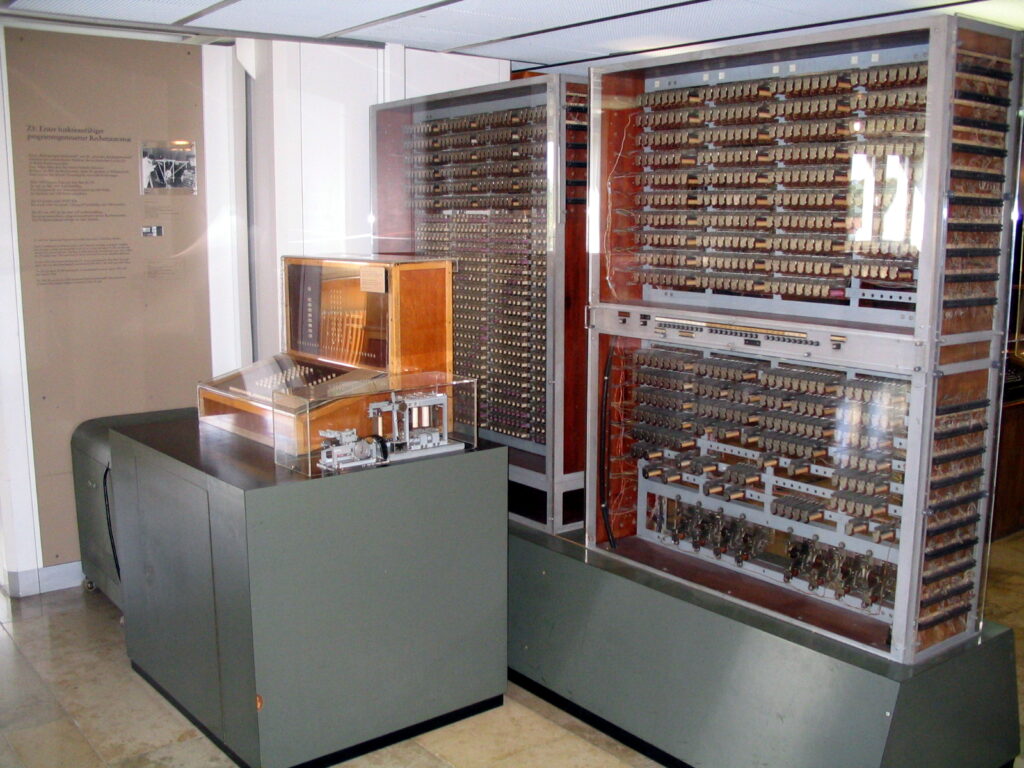

Z3: el visionario solitario que programó el futuro

En la Alemania de 1941, lejos de los focos de los Aliados, un ingeniero llamado Konrad Zuse construía en secreto una máquina diferente. No era una respuesta a la guerra, sino a su propia frustración: como ingeniero civil, pasaba horas haciendo cálculos repetitivos.

Así nació la Z3, la primera computadora electromecánica completamente programable de la historia. Usaba relés telefónicos para procesar datos y podía ejecutar instrucciones condicionales, una característica esencial de las computadoras modernas.

Zuse incluso ideó un lenguaje de programación propio, Plankalkül, años antes de que nadie más pensara en ello.

Pero su trabajo fue ignorado en su tiempo. La Z3 fue destruida por los bombardeos y, por años, su genio pasó desapercibido.

Hoy, sin embargo, reconocemos que Zuse anticipó muchos de los conceptos que definirían el siglo digital. Fue un pionero que, sin saberlo, escribió las primeras líneas de la historia que hoy continuamos.

Pensamiento profundo: una extensión de la mente humana

Años 1950–1960

La guerra había terminado. Las bombas ya no caían, pero algo nuevo empezaba a construirse: una era donde las ideas eran más poderosas que las armas.

Las computadoras que antes ocupaban salones enteros y resolvían trayectorias de misiles comenzaron a transformarse. Ahora se soñaba con algo más grande, más abstracto:

¿Y si estas máquinas no solo calcularan, sino que también pudieran pensar?

Era el inicio de un nuevo tipo de ambición: ya no se trataba de resolver ecuaciones militares o romper códigos enemigos, sino de explorar los límites de la mente misma.

De herramientas a compañeras de pensamiento

Los pioneros de esta época no eran soldados ni espías. Eran matemáticos, filósofos, científicos y visionarios que veían en la computadora no un arma, sino un espejo. Uno que podía ayudarnos a entender cómo pensamos… y tal vez incluso hacerlo por su cuenta.

Aparecen los primeros lenguajes de programación, como Fortran y Lisp. Por primera vez, los humanos pueden hablarle a las máquinas con instrucciones escritas, y las máquinas responden.

Los sistemas operativos comienzan a emerger, y con ellos, la idea de que una computadora no solo ejecuta una orden, sino que puede organizar procesos, tomar decisiones básicas y administrar recursos.

Pero el salto más grande es conceptual: se empieza a hablar de inteligencia artificial.

El nuevo sueño: máquinas que razonen, aprendan, colaboren

En 1950, Alan Turing publicó su famoso artículo “Computing Machinery and Intelligence”, donde preguntaba:

¿Pueden pensar las máquinas?

Turing, propuso una prueba, para determinar si una máquina podía simular una conversación humana sin que el interlocutor lo notara. Hoy en dia conocemos esta prueba como el test de Turing.

Mientras tanto, otros gigantes como John von Neumann, Marvin Minsky y J.C.R. Licklider empezaban a imaginar un futuro donde los humanos y las máquinas trabajarían juntos. Licklider hablaba de un “simbiosis hombre-computadora”, donde las máquinas serían asistentes intelectuales, no reemplazos.

“En vez de programarlas solo para obedecer, soñamos con que algún día puedan entender.”

Este período fue el nacimiento del ideal de la inteligencia artificial como una extensión de nuestra mente, no una imitación.

El inicio de la pregunta infinita

Por primera vez, la humanidad comenzaba a preguntarse en serio:

¿Qué es la inteligencia? ¿Y puede una máquina tenerla?

Se abría un territorio nuevo, inexplorado, casi filosófico. Y las computadoras ya no eran solo herramientas técnicas, sino espejos conceptuales donde mirábamos nuestro propio pensamiento.

Lo que antes era un cálculo balístico, ahora se convertía en una conversación.

Una conversación con la máquina.

Una conversación con nosotros mismos.

El acceso universal al conocimiento

Décadas de 1970–1980

La tecnología ya no estaba reservada solo para científicos, militares o laboratorios secretos.

Una nueva generación empezaba a soñar con algo aún más audaz:

llevar la computadora a todas las casas, a todas las escuelas, a todos los escritorios.

Hasta entonces, las computadoras eran grandes, frías, inaccesibles. Había que tener bata blanca, doctorado o autorización militar para acercarse a una. Pero poco a poco, ese muro fue cayendo.

De cálculo a creatividad: nace la computadora personal

A principios de los años 70, empresas como IBM, DEC y Xerox PARC empezaban a explorar cómo hacer más accesible el poder de cómputo. Pero el verdadero cambio vino desde los garajes, no desde los laboratorios.

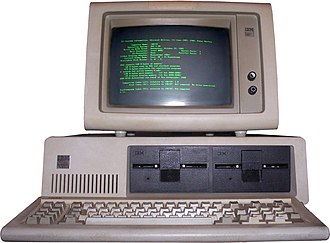

En California, dos jóvenes soñadores Steve Jobs y Steve Wozniak construyeron la Apple I, una computadora personal hecha a mano. Poco después, aparecerían la Apple II, el Commodore 64, el IBM PC…

Y con ellos, la revolución personal computer.

“Una computadora en cada hogar y en cada escritorio”

Bill Gates, años 80

Esta era la nueva promesa: que cualquier persona pudiera crear, aprender, experimentar y expresarse con una máquina que antes solo servía para cálculos científicos.

Las computadoras personales se convirtieron en herramientas de empoderamiento individual. Por primera vez, niños, artistas, escritores y músicos podían usar tecnología para explorar sus ideas.

Soñar la utopía: democratizar el conocimiento

En esta década, la computadora pasó de ser una máquina lógica a una máquina cultural.

Ya no se trataba solo de pensar o razonar. Se trataba de imaginar.

Nacen los primeros videojuegos. Aparecen procesadores de texto. La gente comienza a guardar fotos, escribir cuentos, hacer hojas de cálculo, programar desde su cuarto.

Los hogares empiezan a tener una máquina que ya no solo obedece: colabora.

Aprender a programar se vuelve un superpoder, y miles de jóvenes descubren que pueden decirle a una máquina exactamente lo que quieren que haga.

Educación, creatividad y comunidad

Esta nueva etapa también transformó la educación. Las escuelas comenzaron a incorporar laboratorios de informática. Los niños aprendían a usar Logo, a programar en BASIC, a entender que detrás de cada imagen en la pantalla había una lógica construida.

Las computadoras personales plantaron la semilla de lo que vendría después:

una sociedad conectada por el conocimiento y la expresión digital.

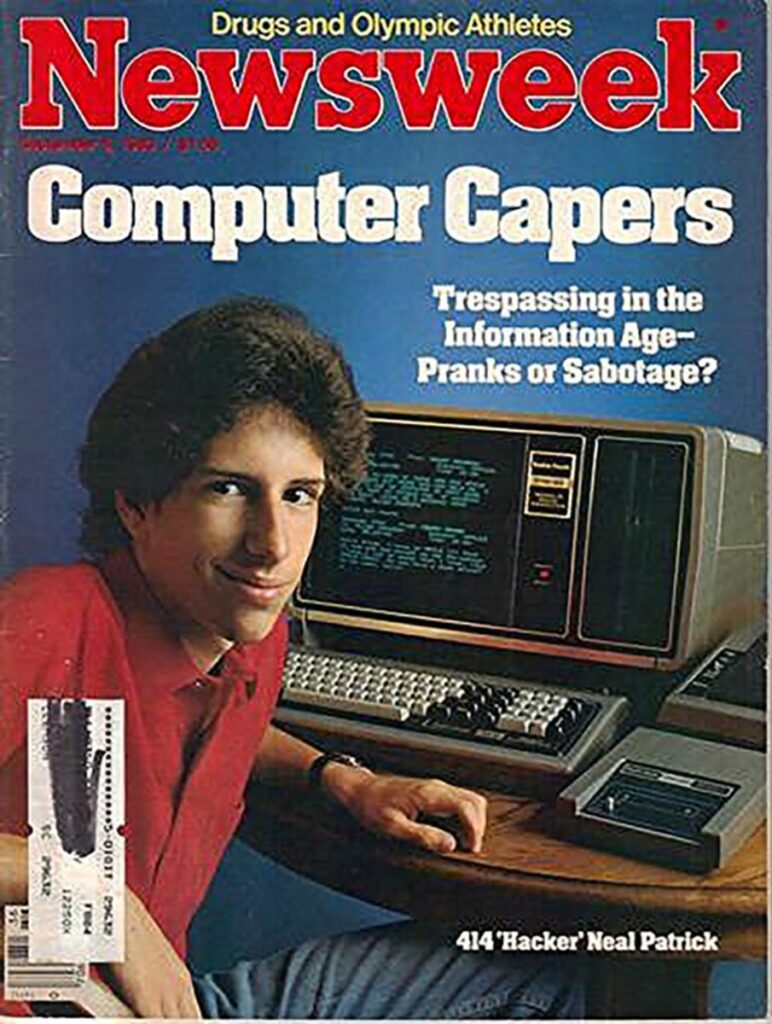

El término “hacker” fue utilizado por primera vez por los medios de comunicación tradicionales el 5 de septiembre de 1983, cuando Neal Patrick, miembro de 17 años de 414s, apareció en la portada de Newsweek.

Patrick se había convertido en el portavoz no oficial de los 414, que ganaron notoriedad a principios de la década de 1980 como un grupo de amigos que irrumpieron en docenas de sistemas informáticos de alto perfil, incluidos los del Laboratorio Nacional de Los Álamos, el Centro de Cáncer Sloan-Kettering y el Security Pacific Bank.

Lo invisible se volvió cotidiano

Antes, una computadora era una rareza. En los 80, empezó a ser como un lápiz, una hoja, un cuaderno, pero con una potencia sin precedentes.

Ya no hacía falta ser un genio para usarla. Bastaba con tener curiosidad.

Y así, el sueño siguió creciendo:

¿Y si en lugar de tener que buscar conocimiento… el conocimiento pudiera venir a nosotros?

Conectar al planeta

Años 1990–2000

La computadora personal había cumplido su promesa: millones de personas ya podían crear, calcular, escribir, jugar… Pero faltaba algo.

Faltaba que todas esas mentes estuvieran conectadas.

Durante años, las computadoras habían trabajado solas, como pequeñas bibliotecas cerradas. Pero en universidades y centros de investigación ya se estaba gestando algo mayor: una forma de enlazarlas, de compartir lo que sabían, de crear una red colectiva de conocimiento.

Ese algo se llamaría Internet.

De la red militar al espacio común

Lo que hoy damos por sentado como hacer una búsqueda en Google, enviar un mensaje, leer esta misma historia ,era una explosión de imaginación en los años 90.

Internet había nacido como un experimento militar (ARPANET), pero cuando se abrió al mundo civil, se convirtió en otra cosa:

una plaza pública digital, una biblioteca infinita, un nuevo continente humano.

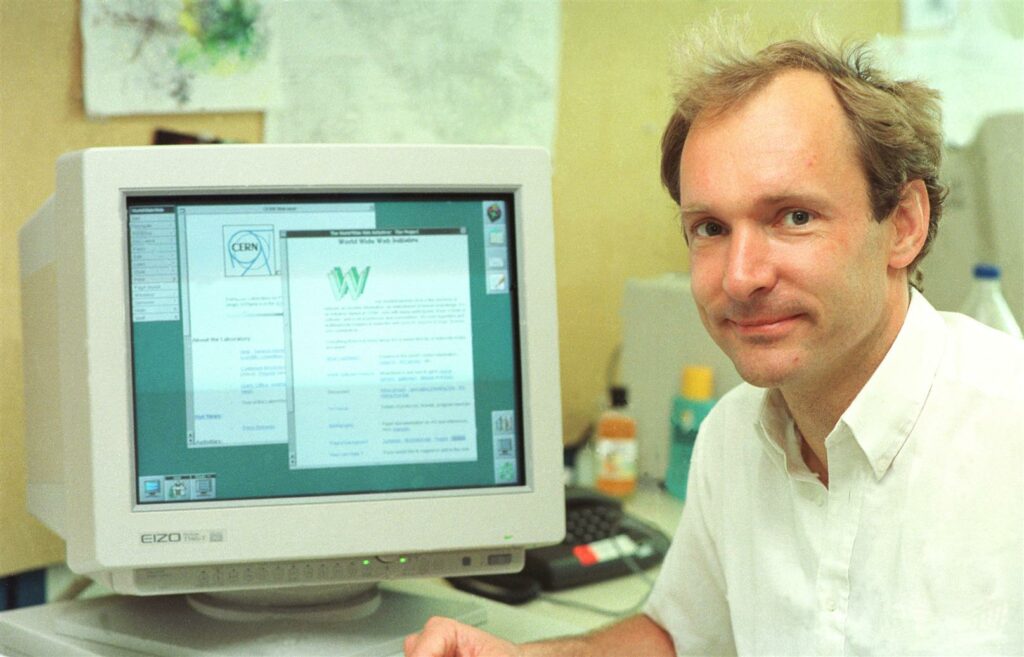

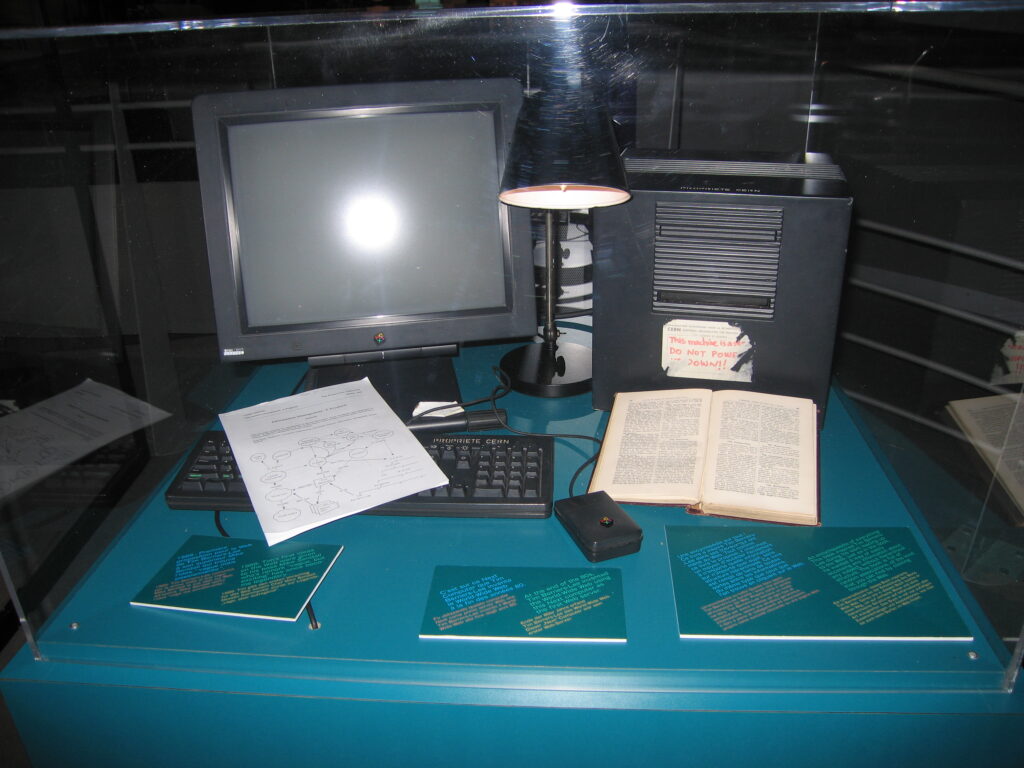

La Web, inventada por Tim Berners-Lee en 1989 en el CERN, hizo que la información fuera navegable, visual y accesible. Ya no eran solo científicos compartiendo datos:

ahora cualquier persona, en cualquier lugar, podía publicar una página web, mandar un correo, chatear.

La aldea global se vuelve realidad

El ideal de los años 90 era simple pero poderoso:

romper fronteras con cables.

Que un estudiante en Brasil pudiera leer una enciclopedia en Inglaterra.

Que una doctora en Nigeria pudiera consultar investigaciones de Japón.

Internet democratizó el acceso al saber, el correo electrónico reemplazó cartas y las primeras comunidades virtuales unieron personas por intereses, no por geografía.

Comienza la era de la educación abierta, los foros, las bibliotecas digitales.

La humanidad más conectada, más informada, más igualitaria esta por lanzarse a una revolución que superara con creces a los siglos de historia y de invención. Internet nos ha abierto el futuro tecnológico.

Unir a la humanidad

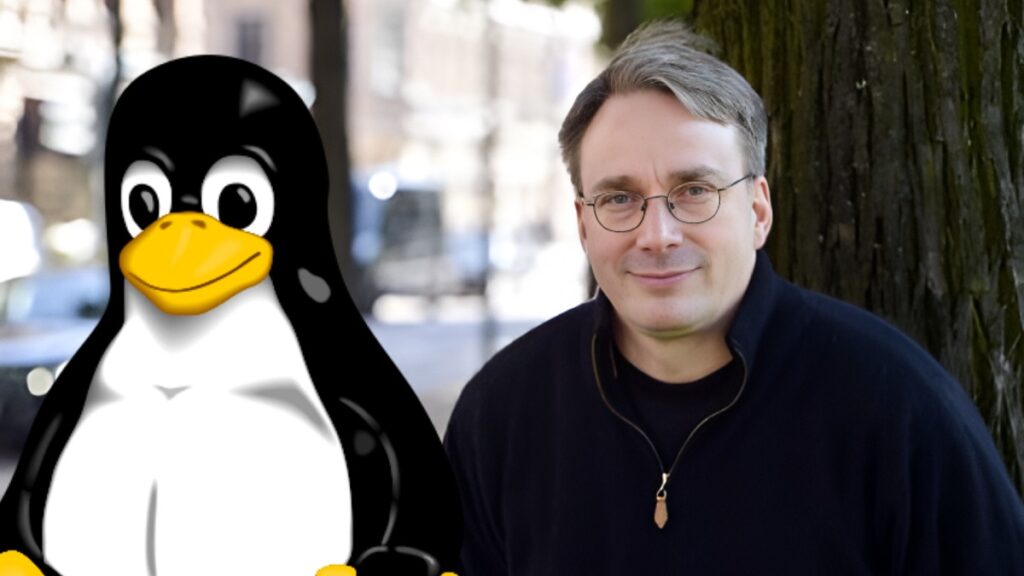

Linus Torvalds creó Linux en 1991 con el objetivo de tener un sistema operativo similar a Unix, pero más accesible y flexible, especialmente para su uso en la PC que estaba utilizando. También quería crear un sistema operativo de código abierto, permitiendo a la comunidad colaborar y mejorar el proyecto.

Las empresas tecnológicas entendieron rápido el potencial.

Nacen gigantes como Google (1998), Wikipedia (2001), Amazon, Yahoo, eBay…

Cada una amplió la frontera: buscar, aprender, comprar, colaborar… todo desde una pantalla.

Los gobiernos y ONGs también se sumaron: alfabetización digital, salud en línea, acceso rural…

La conexión ya no era solo técnica: era social, política, cultural.

Y sí, también empezó la otra cara: el riesgo de desinformación, la brecha digital, los conflictos éticos. Pero en esencia, el sueño era luminoso: Conectarnos no para consumir, sino para conocernos.

Internet: el gran espejo colectivo

Con la llegada del nuevo milenio, el mundo había cambiado para siempre.

Ya no importaba solo qué sabía tu computadora.

Importaba a qué otras computadoras estaba conectada.

Y con ellas, a cuántas otras mentes podías llegar.

El sueño de conectar a la humanidad ya no era una metáfora o una idea teórica, sino realidad.

Desarrollo web

Descubre mas sobre la historia de internet y el desarrollo web en esta pagina!

Nunca inventamos tan rápido, pero…

En apenas tres décadas, hemos pasado de enviar cartas a segundos de distancia, de encender módems ruidosos a hablar con inteligencias artificiales, de mirar la televisión a transmitir nuestras propias vidas en directo.

Hemos inventado más que nunca, sí. Pero también hemos descubierto algo más profundo:

que la verdadera invención no es solo tecnológica… es humana.

Creamos máquinas más poderosas, pero también nuevas formas de pensar, de sentir, de relacionarnos.

Internet nos conectó, pero ahora el reto es mayor:

Los próximos pasos ya no se tratarán solo de velocidad o innovación.

Se tratarán de sentido, ética y reeducación.

Y así, con todos los cables tendidos,

con millones de mentes enlazadas,

la humanidad se prepara para un nuevo capítulo:

el de las máquinas que ya no solo obedecen…

sino que entienden.

Chatgtp -4o

El presente y futuro:

Década de 2020 en adelante

Después de conectar el planeta, ¿qué más podía soñar la humanidad?

La respuesta no fue más velocidad, ni más pantallas, ni siquiera más datos.

Fue algo más sutil, más humano:

crear máquinas que nos entiendan. Que aprendan, ayuden, acompañen.

No bastaba con que las computadoras hicieran cálculos, o que internet nos informara.

Ahora queríamos que la tecnología pensara con nosotros.

Que supiera escuchar, ver, que aprendiera a enseñar, a cuidar, incluso a crear.

De comandos a conversación

En nuestro presente, la forma de interactuar con la tecnología a dado un giro radical:

Ya no hace falta programar con código, ni entender algoritmos.

Ahora hablamos. Y las máquinas responden.

Desde asistentes virtuales hasta inteligencias artificiales que escriben, dibujan o componen música, entramos en la era donde la tecnología interpreta nuestro lenguaje natural.

La línea entre herramienta y colaborador se vuelve más difusa cada día.

Tecnología al servicio del bien común

La inteligencia artificial se está usando para:

- Ayudar a médicos a detectar enfermedades antes de que aparezcan síntomas.

- Enseñar a niños con métodos adaptativos en cualquier idioma.

- Acompañar a personas mayores que viven solas.

- Diseñar soluciones a la crisis climática o la gestión de recursos.

- Asistir en terapias psicológicas o rehabilitación cognitiva.

Por primera vez, el sueño no es solo técnico.

Es ético.

No basta con que la tecnología funcione: debe hacer el bien y usarse con fines éticos.

Debe ser justa, transparente, incluyente y sustentable.

¿Y ahora qué soñamos?

Estamos en una encrucijada histórica, hemos creado inteligencias que aprenden… Y ahora nos toca enseñarles lo que realmente importa.

Ya no se trata solo de “lo que pueden hacer”, sino de:

¿para qué?

¿Con quién?

¿A qué costo?

La humanidad ha inventado más que nunca, pero también ha llegado al punto donde necesita pensar más que nunca. No sobre cómo acelerar el futuro… sino sobre cómo dirigirlo.

¿Es un sueño o una pesadilla?

A lo largo de esta historia, hemos visto cómo el sueño de la humanidad dio forma a la tecnología.

Pero también es cierto que, cada vez que creamos una herramienta poderosa, creamos también un riesgo.

Hoy, más que nunca, la pregunta no es qué puede hacer la tecnología, sino qué hacemos nosotros con ese poder.

Los riesgos que enfrentamos

1. Desinformación masiva

Las mismas redes que nos conectan pueden difundir mentiras más rápido que nunca.

¿Quién decide qué es verdad cuando una IA puede falsificar la voz de un presidente o el rostro de un testigo? Hoy en día mas que nunca la humanidad esta consumiendo mentiras constantemente y no parece que se este regulando favorablemente.

2. Pérdida de privacidad

Cada clic, cada búsqueda, cada conversación queda registrada.

¿Estamos cediendo nuestra intimidad a cambio de comodidad? La información es poder y antes de la llegada de la IA grandes multinacionales ya se han dedicado a robar y usar indebidamente nuestros datos, hoy en día, sigue pasando y se entrenan modelos de IA con todo tipo de contenido sin excepción ni ética.

3. Desigualdad digital

La tecnología puede empoderar… pero también excluir. ¿Quién queda atrás cuando el mundo se mueve a la velocidad del silicio? Futurama predijo un futuro como un tecno feudalismo donde unos pocos amasan todo el poder gracias a la tecnología, los retos que tenemos como civilización en pleno siglo XXI no son pocos y podemos terminar cediendo derechos y libertades en favor de unos pocos.

4. Dependencia y deshumanización

Si dejamos que las máquinas decidan por nosotros, ¿perderemos la capacidad de pensar, de discernir, de sentir? Aun que han pasado solo 35 años desde la invención de internet, aun seguimos siendo una especie con un juguete nuevo, son muchos los casos de adicción a las tecnologías, a las distintas plataformas como redes sociales, las cuales están preparadas con un algoritmo que lo que busca es darnos una recompensa rápida de serotonina. Hoy en día ante un acto de deshumanización es mas fácil ver los teléfonos móviles alzados que la gente movilizándose para parar el acto.

5. Autonomía de las máquinas

Algunas IA ya pueden programarse, mejorar y replicarse. ¿Qué pasa si cruzamos el umbral de lo que podemos controlar? en 1950 Alan Turing creo el Test de Turing, un test especializado para maquinas para poder saber cuando una maquina deja de ser percibida como una maquina.

Las AGI son una idea con mas de 80 años de antigüedad y ha sido representada en el cine en diversas obras cineastas como Terminator o una odisea en el espacio, hasta Casandra una nueva serie alemana de terror.

El verdadero desafío: gobernar el futuro

No hay vuelta atrás. Ya hemos creado herramientas más inteligentes, más rápidas y más potentes que nunca. Ahora nos toca lo más difícil: enseñarles nuestros valores y recordarnos los nuestros.

La tecnología no es ni buena ni mala, pero tampoco neutral.

Melvin Kranzberg, historiador de la tecnología

¿Y si el próximo gran invento fuera ético?

Tal vez el próximo avance no será un chip más pequeño ni una IA más veloz…

Tal vez será una generación que sepa cuándo decir “no”.

Que ponga límites. Que use la tecnología como un puente, no como una barrera.

Como una herramienta para cuidar, no para dominar.

Porque el sueño de la humanidad nunca fue solo construir máquinas.

Fue construir un futuro en el que valga la pena vivir.

Y ese futuro todavía depende de nosotros.

Puede interesarte:

HTML

HTML (Lenguaje de Marcas de Hipertexto, del inglés HyperText Markup Language) es el componente más básico de la Web. Define el significado y la estructura del contenido web.

CSS

CSS es el lenguaje de estilos utilizado para describir la presentación de documentos HTML.

Javascript

JavaScript es el lenguaje de programación que debes usar para añadir características interactivas a tu sitio web.